تصور کنید یکی از نزدیکانتان با شما تماس تصویری میگیرد و میخواهد به سرعت مبلغی پول به یک شماره حساب واریز کنید. ساعتی بعد برادر یا خواهر خود را میبینید و از او میپرسید که مسئله چه بوده است اما او روحش هم از چنین چیزی خبر ندارد. مسئله چیست؟ شما شک ندارید که کسی که با شما تماس گرفت برادر یا خواهر شما بوده است با همان صدا و همان چهره. احتمالاً شما فریب پدیدهای به نام «دیپ فیک» را خوردهاید.

ساخت یک کپی از خودتان

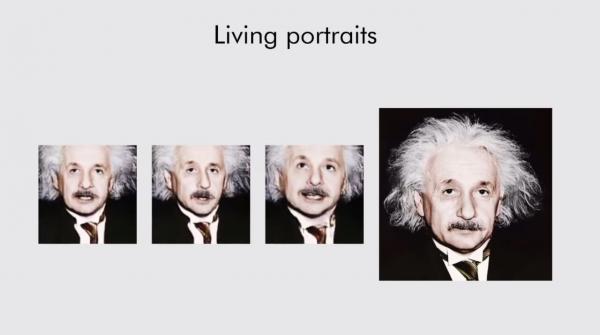

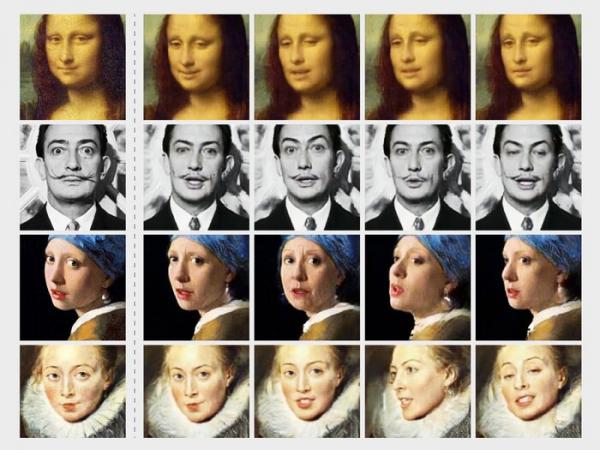

دیپ فیک یا جعل عمیق، یک تکنیک است که به کمک دوربین حالتهای مختلف چهره یک نفر را در موقعیتهای مختلف مانند حرف زدن، حرکت کردن و هر حالت دیگر، تشخیص میدهد و سپس به کمک هوش مصنوعی میتواند آن حالتها را بر روی چهره فرد دیگری کاملاً کپی کند. در نتیجه شما رفتارهایی را از کسی میبینید در حالی که آن فرد در واقعیت هیچ وقت آن چیزها را نگفته یا آن کارها را انجام نداده است. دیپ فیک ترکیبی از دو واژه یادگیری عمیق (Deep Learning) و جعل(Fake) است. این فناوری میتواند محتوای صوتی و تصویری را به دلخواه تغییر دهد.

دیپ فیک بر دو سیستم استوار است. یکی از سیستمها خلق میکند و دیگری تشخیص میدهد. در فرایند خلق کردن، سیستم یک چهره یا صدا را دریافت کرده و تلاش میکند آن را عیناً خلق کند، سیستم دوم این محصول را با نسخه اصلیش مقایسه کرده و شباهت چیزی که تولید شده با اصل آن را بررسی میکند. فرایند خلق و تأیید آنقدر تکرار میشود تا چهره یا صدایی که مورد نظر است عیناً ساخته شود.

اما این همه ماجرا نیست. همین چند وقت پیش بود که ویدئویی از باراک اوباما در فضای مجازی دست به دست شد که در آن رئیس جمهور سابق آمریکا درباره خطر گسترش پدیدهای به نام دیپ فیک صحبت میکرد. اما همان ویدئو هم با تکنیک دیپ فیک ساخته شده بود! در حقیقت هیچ ابزاری وجود ندارد که جعلی بودن ویدئوی ساخته شده با دیپ فیک را اثبات کند. به همین دلیل محققان در حال تلاش برای ساخت نرمافزارهای تشخیصی هستند.

دیپ فیک از کجا آمد؟

ماجرا از سال ۲۰۱۷ شروع شد. یک کاربر اینترنت که اسم خودش را «دیپ فیک» گذاشته بود، با استفاده از یک الگو تلاش کرد چهره سلبریتیها را روی فیلمهای مستهجن کپی کند. هرچند جلوی کار او گرفته شد اما بعد از این حرکت بود که موجی از چنین کپی کردنهایی به راه افتاد و ویدئوهای دیپ فیک زیادی در حوزههای مختلف ساخته شد. کارشناسان میگویند که حدود ۱۰۰۰۰ ویدئوی جعلی در سرتاسر اینترنت در حال گردش است و همچنان هم ادامه دارد. از این تعداد ویدئو بیشتر از ۸۰۰۰ ویدئو مستهجن محسوب میشوند. برنامههایی مانند FakeApp ، DeepFaceLab، FaceSwap و myFakeApp برنامههایی هستند که نمونه ساده شده این تکنیک را ارائه میکنند.

البته چند سال است که برنامهای به نام FaceApp حسابی بین کاربران گوشیهای هوشمند معروف شده است. این برنامه امکاناتی مثل تبدیل چهره آنها به مدل پیر شده خودشان و جابهجایی حالت چهره دو نفر را دارد. این مدل برنامهها نمونههای ساده شده تکنیک دیپ فیک هستند.

نیمه تاریک و روشن ماجرا

مثل هر تکنولوژی جدیدی، دیپ فیک هم اثرات مثبت و منفی خودش را دارد. یکی از پیامدهای منفی این ماجرا، استفاده از این تکنیک در ساخت فیلمهای مستهجن است. به صورتی که افراد میتوانند از این قابلیت در ساخت فیلمهای جعلی غیراخلاقی استفاده کنند. مشکل دیگر استفاده از این تکنیک در فعالیتهای مجرمانه و انواع کلاهبرداری است. همچنین گروههای مختلف سیاسی میتوانند با استفاده از دیپ فیک ویدئوهای جعلی از سیاستمداران مختلف ساخته و بر مسائل سیاسی و انتخاباتی تأثیر بگذارد.

البته دیپ فیک کاربردهای مفیدتری هم دارد. سینما، بازار و تبلیغات از بزرگترین کاربران این تکنولوژی هستند. یکی از مفیدترین ویدئوهای مثبتی که به کمک دیپ فیک تولید شد، ویدئویی از یک فوتبالیست مشهور خارجی بود که به ۹ زبان درباره خطرات ابتلا به بیماری مالاریا توضیح میداد. همچنین یکی از مهمترین کاربردهای این تکنولوژی در دوبله است که میتوان فیلمها را با صدا و تصویر بازیگر دوبله کرد و این مسئله به معنای خداحافظی با زیرنویس است.

- 17

- 5